La protección contra bots y ataques DDoS para un sitio WordPress es una necesidad para la mayoría de los proyectos modernos de Internet. Ya no es un secreto para nadie: un aumento en la actividad en un sitio web no siempre significa una influencia de visitantes reales, lo mormal es un ataque DDoS. Mucho más a menudo es el resultado de una invasión de bots y spammers, lo que como resultado aumenta la carga en el sitio, aumenta la cantidad de spam y pone en peligro sus datos y sus recursos.

¿Cómo identificar un robot?

¿Cómo identificar un robot?

Los bots visitan sitios web todo el tiempo; es parte de la Internet moderna que incluso los motores de búsqueda indexen los recursos de esta manera. Pero con la ayuda de un robot (o un escáner automático) también puedes analizar los datos, es decir. Recuperar información de los recursos de la red.

Los bots visitan sitios web todo el tiempo; es parte de la Internet moderna que incluso los motores de búsqueda indexen los recursos de esta manera. Pero con la ayuda de un robot (o un escáner automático) también puedes analizar los datos, es decir. Recuperar información de los recursos de la red.

Un bot que hace esto es un programa o script que realiza acciones automatizadas simples en un sitio web: carga el código de la página, lo descompone en los elementos que lo componen, extrae los datos y los guarda en una base de datos.

El propósito de dicha recopilación puede varias. En la mayoría de los casos, los sitios web se analizan para obtener ciertos datos de las páginas de la competencia, que luego pueden utilizar para explotar sus propios recursos, así como para realizar ataques maliciosos, pero el análisis también se realiza con fines analíticos o de investigación, No significa nada malo en sí mismo.

- Robots de búsqueda o rastreadores web. Este es un tipo de bot que rastrea e indexa información de sitios web para su posterior inclusión en la base de datos del motor de búsqueda. Por lo tanto, Google tienen sus propios rastreadores, y es más probable que sus acciones ayuden al propietario del sitio que lo perjudiquen, ya que es con su ayuda que se logra la promoción SEO del sitio y la afluencia de tráfico de los motores de búsqueda. se lleva a cabo.

- Programas Analizadores o raspadores web. Estos bots recopilan principalmente información de sitios web para revenderla a las partes interesadas. Por ejemplo, las empresas competidoras pueden recibir información sobre precios, fotografías y gamas de productos de otras tiendas online recopiladas por analizadores. Este análisis se lleva a cabo mediante robots de búsqueda utilizados para obtener un determinado tipo de datos, escáneres HTML, raspadores de pantalla basados en navegadores, así como servicios de análisis especiales.

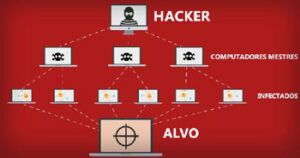

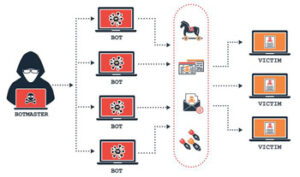

- Los Bots maliciosos. Una categoría separada son los bots, que se crean con el propósito de piratear y deshabilitar sitios. Estos robots escanean el sitio no en busca de la información contenida allí, sino principalmente en busca de componentes vulnerables en los que se puedan implementar elementos de control remoto o acciones maliciosas. Algunos de estos bots atacan el sitio directamente, generalmente aquellos que están escritos específicamente para llevar a cabo ataques DDoS (denegación de servicio), diseñados para crear condiciones tales que los usuarios ya no puedan acceder al recurso. Los principales clientes de este tipo de ataques son los competidores que quieren desactivar a su oponente o al menos causarle daños, privando temporalmente al sitio de su funcionalidad.

¿Cómo deshacerse de los bots en el sitio? No será posible hacer esto por completo, así como es imposible eliminar por completo la copia del contenido de su sitio. Por un lado, es imposible prohibir legalmente el uso de bots en su recurso y no es necesario; Después de todo, los motores de búsqueda también descubren sobre usted a través de bots. Por otro lado, los ataques DDoS se consideran un acto grave, criminal y perseguido internacionalmente que puede causar pérdidas colosales y por el que se pueden imponer penas de prisión reales. Considerándolo todo. Debe protegerse contra DDoS con el mismo cuidado con el que se protege contra robos o ataques armados desde Multidisc le ofrecemos ayuda para la protección de sus datos.

Métodos de detección de Bots

Métodos de detección de Bots

La protección contra bots individuales o incluso la protección integral contra botnets se basa en un principio: primero hay que rastrear el tráfico no deseado. Para determinar si el impacto del tráfico es causado por un ataque de bot, puede utilizar los siguientes métodos:

- Puede realizar un seguimiento de las estadísticas de acceso accediendo al registro del servidor mediante el archivo .haccess.log. Este es un archivo de texto que contiene información completa sobre el tráfico en el servidor. Allí podrá ver la dirección IP desde la que se realizó la solicitud, la hora, tipo y contenido de la solicitud. Preste especial atención aquí al parámetro {User-Agent}, este encabezado contiene información sobre la solicitud, es decir, la aplicación y el idioma en el que se realizó la solicitud. Las solicitudes repetidas de la misma IP y el mismo agente de usuario de forma regular deberían alertarlo.

- El uso de JavaScript puede ayudar a recopilar mucha información sobre los usuarios que visitan el sitio web (resolución de pantalla, zona horaria, botones en los que se hace clic). Combinado con los datos de registro, es posible identificar qué usuario es el que tiene más probabilidades de resolver simplemente comparando la información sobre la solicitud.

Las solicitudes no deseadas que provienen de agentes con la misma solicitud, región, zona horaria y tamaño de pantalla, que provienen de la misma IP, se pueden bloquear de forma segura utilizando uno de los métodos que describiremos a continuación.

¡Importante! Es posible que no todas las solicitudes de bot provengan de la misma dirección IP. Normalmente, los bots utilizan un proxy rojo, realizando así raspado distribuido. Sin embargo, si se reciben solicitudes idénticas incluso de diferentes servidores, lo más probable es que este sea el motivo del bloqueo.

Protección contra bots en WordPress

Protección contra bots en WordPress

Como ya se mencionó, es imposible deshacerse completamente de los bots de una vez por todas, pero hay muchas maneras de limitar su actividad. Veamos algunos de los más efectivos:

- La forma más sencilla es confiar este trabajo en un servicio profesionales de Multidisc. Cada cliente nuestro recibe protección básica contra bots y está protegido contra robots maliciosos, arañas, ladrones de contenido y ataques de piratas informáticos mediante el servicio BotGuard . ¡A partir de ahora no tendrás miedo de los ataques DDoS, la copia de contenido ni el acceso a vulnerabilidades de recursos!

Una de las formas más sencillas y casi universales de combatir los bots es crear un filtro por Agente de Usuario en los archivos .htaccess (acceso a hipertexto) y robots.txt. Estos archivos se encuentran en la raíz de su sitio en el servidor, y se accede a ellos a través de la cuenta de configuración de alojamiento. Si no hay archivos con ese nombre allí, deben crearse con el Bloc de notas, cambiarles el nombre en consecuencia y cargarse en el directorio raíz. A continuación, en estos archivos debe crear reglas para agentes de usuario dudosos específicos que descubrió a través de los registros del servidor y JavaScript.

- Para restringir el .htaccess, debe insertar el siguiente texto en el archivo:

RewriteCond %{HTTP_USER_AGENT} Nombre_de_usuario

RewriteRule (.*) – [F,L] - Puedes restringir el acceso a través de robots.txt ya sea parcial o completamente. Para cerrar resultados específicos para el bot, escriba el siguiente texto:

User-agent: nombre_bot

Disallow:/nombre_sección/

Disallow:/mensajes/ - Para restringir un sitio por completo:

User-agent: nombre_bot

Disallow:/ - También puedes reducir el número de visitas de un bot específico:

User-agent: nombre_bot

Crawl-delay: 10

- Para restringir el .htaccess, debe insertar el siguiente texto en el archivo:

- También se recomienda limitar el acceso de solicitudes con un agente de usuario vacío, lo que se encuentra con mayor frecuencia en bots mal escritos, donde simplemente fueron demasiado vagos para ingresar el valor.

La mayoría de los analizadores no distinguen los resultados de búsqueda reales de los honeypots, mientras que un visitante real no verá ese resultado en absoluto gracias al elemento de ocultación de contenido (CSS) incorporado. Sin embargo, el texto y la dirección de dichas trampas deben cambiarse periódicamente, porque gradualmente los robots aprenderán a evitarlas.

¡Importante!Tenga en cuenta que para garantizar que el acceso al sitio no esté bloqueado para los robots de búsqueda de “sombrero blanco”, así como para los robots de análisis, por ejemplo, para los robots de Google, debe desactivar /scrapertrap/ en los robots. archivo de texto.

¡Importante!Tenga en cuenta que para garantizar que el acceso al sitio no esté bloqueado para los robots de búsqueda de “sombrero blanco”, así como para los robots de análisis, por ejemplo, para los robots de Google, debe desactivar /scrapertrap/ en los robots. archivo de texto. - Cualquiera que sea el método que elija, debe tener en cuenta que los bots modernos y bien escritos imitan con bastante habilidad el comportamiento humano en línea, y es importante tener esto en cuenta para que, junto con los bots, no se proteja accidentalmente de los visitantes reales de su sitio. y también evita que se bloqueen rastreadores útiles y no perjudica la optimización SEO. Por lo tanto, actúe con prudencia y cuidado.

Protección contra ataques DDoS

Protección contra ataques DDoS

Cuando hablamos de bots maliciosos, no podemos ignorar la cuestión de la defensa contra ataques DDoS. Actualmente, esta cuestión es especialmente relevante para determinadas áreas de actividad específicas. Estos incluyen sitios web de tiendas en línea, juegos multijugador en línea, bolsas de valores y plataformas de inversión, y otros recursos comerciales. A veces, la política agresiva de un competidor de intentar desactivar su recurso puede desencadenar un ataque DDoS en el sitio, pero a veces el recurso también es atacado por hackers y extorsionadores, y otras veces puede ser atacado sólo por diversión sin ninguna intención maliciosa. Objetivo. De todos modos, cualquier proyecto serio debe estar protegido contra estos ataques.

Normalmente, los ataques DDoS se describen en el modelo OSI de siete capas. La primera capa de la red es la capa física y la segunda capa es el canal (la red está conectada en la capa del canal a través de conmutadores). Cuanto más alta es la capa, más abstracta es. Los ataques DDoS pueden ser de bajo nivel o avanzados. El nivel más bajo de ataques se produce en la red, del nivel tres al cinco: “bloquean” el canal con solicitudes de ping o solicitudes de conexión TCP (las llamadas solicitudes SYN) y son fáciles de contrarrestar. Pero cuanto mayor sea el nivel de ataque, más difícil será defender.

Normalmente, los ataques DDoS se describen en el modelo OSI de siete capas. La primera capa de la red es la capa física y la segunda capa es el canal (la red está conectada en la capa del canal a través de conmutadores). Cuanto más alta es la capa, más abstracta es. Los ataques DDoS pueden ser de bajo nivel o avanzados. El nivel más bajo de ataques se produce en la red, del nivel tres al cinco: “bloquean” el canal con solicitudes de ping o solicitudes de conexión TCP (las llamadas solicitudes SYN) y son fáciles de contrarrestar. Pero cuanto mayor sea el nivel de ataque, más difícil será defender.

Los ataques de alto nivel, nivel 7, son más peligrosos. Están dirigidos a las páginas más pesadas del sitio o realizan acciones complejas en él, por ejemplo, configurando un filtro de catálogo para mostrar la máxima selección de productos. El ataque lo llevan a cabo cientos o kilómetros de robots; Una denegación de servicio puede ser desde el servidor web, soporte o servidor de base de datos.

Para manejar este tipo de ataques, utilizamos WAF (Web Application Firewall), un sistema especial de monitores y filtros diseñado para detectar y bloquear ataques de red en una aplicación web. Sin embargo, este es un nivel de ataque bastante alto y solo habilitamos WAF en los casos más graves; Por norma general, la protección básica habilitada por defecto en todos nuestros servidores es suficiente.

Si su sitio está alojado en su computadora en su sala de servidores, probablemente tendrá que lidiar con el ataque usted mismo. Para desbloquear su sitio, necesita conectar una dirección IP adicional o un servicio especializado; en algunos casos, cambiar a un VDS o un servidor dedicado, al que ya están conectados servicios similares, puede ser una buena opción. Después de todo, ¡solo puedes esperar un ataque masivo!

Pero lo mejor, por supuesto, es tener un host confiable en quien puedas delegar la protección del sitio contra DDoS. Por nuestra parte, en Multidisc siempre somos responsables de la seguridad de los proyectos de nuestros clientes, por lo que sólo trabajando con nosotros te librarás de este dolor de cabeza. La protección DDoS está habilitada de forma predeterminada para todas nuestras redes, puedes activar el plan inicial de protección anti-bot de forma gratuita y es posible conectar protección WAF o DDoS de nivel 7 y la protección anti-bot Botguard extendida.

La protección contra bots y ataques DDoS de un sitio web es un proceso minucioso y continuo. Puedes hacerlo tú mismo o confiártelo a Multidisc : todos nuestros clientes tienen una protección básica y pueden recibir rápidamente asistencia adicional en cualquier momento. Se incluye protección confiable contra bots maliciosos y DDoS para los clientes.

Otros artículos que te pueden ayudar a tener tu Gestor de Contenidos al día

![]() ¿Soluciones error 500 en WordPress [1/2]?

¿Soluciones error 500 en WordPress [1/2]?

![]() ¿Soluciones error 500 en WordPress [2/2]?

¿Soluciones error 500 en WordPress [2/2]?

![]() ¿Errores más comunes en WordPress?

¿Errores más comunes en WordPress?

![]() ¿Fallos frecuentes en WordPress?

¿Fallos frecuentes en WordPress?

![]() ¿Problemas frecuentes en WordPress?

¿Problemas frecuentes en WordPress?

Nuestra empresa de servicios Multidisc, contamos con 25 años de experiencia ofreciendo soluciones integrales para tu presencia en la web. Nos especializamos en:

Verifique su conexión a Internet y la URL del sitio Para solucionar este problema, asegúrese de tener una conexión a Internet activa antes de publicar su contenido. Abra su navegador en una nueva pestaña y busque algo en línea.

- Soluciones Web: Desarrollo y mantenimiento de sitios web.

- Limpieza de Virus Online: Eliminación completa de malware y virus.

- Optimización de WordPress: Mejora del rendimiento y velocidad de carga.

- Resolución de Errores: Solución de errores 400, 500 y problemas con versiones de PHP.

- Desarrollo Web desde Cero: Creación de sitios web personalizados.

- SEO Personalizado: Posicionamiento web para mejorar tu visibilidad en buscadores.